Я сразу по сути: что именно умеет Gemini от Google, как его встроить в ваши процессы, где он выигрывает у привычных вам LLM и что делать, если внутри компании строгий регламент по данным. Расскажу на примерах из автоматизации и AI-агентности, с акцентом на n8n и Make.com. Покажу, как собирать пайплайны вокруг мультимодальности — текст, картинки, PDF, код — и как не потерять контроль над качеством и метриками. Сейчас это актуально, потому что мультиканальные процессы расползаются по инструментам, а менеджер и аналитик хотят возвращать себе часы. Этот разбор для тех, кто строит контентные и операционные конвейеры, девопсит интеграции и любит честные цифры вместо магии.

Время чтения: ~15 минут

Когда процессы требуют не фокусника, а инженера

У меня обычно всё начинается одинаково: в кружке уже остыл кофе, а бэклог на автоматизацию пухнет, как корзина почты после праздников. В этот момент выбираю не модный заголовок, а конкретный двигатель процесса. Gemini показал себя именно таким двигателем — мультимодальным и спокойным. Он принимает текст, изображения, аудио, видео и код, и умеет работать там, где задача не укладывается в один тип данных. Историческая справка короткая: семейство моделей Google DeepMind, объявлен 6 декабря 2023 года, преемник LaMDA и PaLM 2, линейка Ultra, Pro, Flash, Nano, плюс чат-бот Gemini для повседневки. И да, я тоже люблю объективную картинку без фанатизма.

Меня как бывшего внутреннего аудитора больше волнуют не красивые демо, а вопрос: насколько модель впишется в оперрутинку, будет ли измеряемой, и как с ней интегрируетcя ваш стек. На стороне Google видно движение в продукты: в Workspace можно выгружать логи работы пользователей с ассистентом в BigQuery и разбирать, что реально происходит. В AppSheet Enterprise Plus появились AI-задачи на базе Gemini — распознавать картинки, читать сложные PDF, вытаскивать сущности из неструктурированного текста. В переводе на человеческий это значит: ближе к кнопке автоматизации, меньше ручных слотов и «сходим в отдел, подождите». Запомните эту мысль, она дальше пригодится.

Инженерия автоматики — это не один большой умный шаг, а сотня маленьких, повторяемых и проверяемых.

И ещё одно наблюдение: по состоянию на весну 2025, обзоры от ИИ в поиске Google заметно присутствуют в выдаче, а Gemini 2.5 Pro радует расширенным контекстным окном и рассуждениями на сложных задачах. Это не аргумент «берите быстрее», это сигнал, что вокруг модели строится экосистема. А экосистема — это интеграции, SDK, логи, лимиты и уже очень практичные паттерны внедрения. Тут я и подключаю свой любимый инструментальный набор.

Gemini без мифов: что это и куда растет

Линейка моделей и задачи под каждую

Обозначу роли в семье. Gemini Ultra — для самых сложных кейсов, где важен максимум качества и длинные рассуждения. Pro — универсальная рабочая лошадка для бэкенд-автоматизаций и агентов. Flash — когда нужно много быстрых откликов и низкая задержка, например, в потоковой обработке или внутренних чатах поддержки. Nano — на устройстве и в краевом вычислении, когда ценен офлайн и приватность. Чат-бот Gemini — фронт для пользователя, но в процессах я обычно ухожу под API, чтобы управлять подсказками, контекстом и метриками.

Ключевая особенность — мультимодальность. Можно передать текстовое описание, пару изображений, кусок аудио стенограммы и код, а на выходе получить агрегированный ответ. Это разговаривает с реальным бизнесом: техподдержка видит скриншот ошибки, саппорт получает расшифровку звонка, а бэкенд — SQL-скрипт для выборки инцидентов. В отличие от сугубо текстовых моделей, здесь удобно строить мостики между отделами, где у одного PDF, у второго таблица, у третьего картинка.

Почему сейчас это важно для процессов

Интеграции растут вокруг реальных рабочих инструментов. В Google Workspace появились экспортируемые логи взаимодействий с ассистентом в BigQuery, так что аналитика перестает быть черным ящиком. AppSheet Enterprise Plus научился ставить ИИ-задачи на базе Gemini — извлекать поля из сканов, классифицировать запросы, прикручивать проверки. Добавьте сюда тренд на AI Overviews в поиске — компании быстрее получают контентные ответы, а это влияет на воронки взаимодействий с клиентом и на внутренние базы знаний.

Чтобы картины не были абстрактными, я держу на столе схемы сравнений. Они дисциплинируют требования: где нужна скорость, где качество, где локальная обработка. Ниже прикладываю инфографику, которую однажды собирала для внутреннего воркшопа.

Если у вас разношерстные источники данных, а команда ценит контроль и логи, Gemini зайдет как центральный узел. Дальше важно грамотно обвязать его сценариями и не потерять прозрачность.

Где место Gemini в бизнес-процессах

Три типовых контура

Первый контур — контентные конвейеры. Генерация черновиков, резюмирование стенограммы созвона, подготовка иллюстраций и схем. Здесь выигрывает связка Gemini + календарь встреч + заметки — выдается аккуратное summary, тезисы и список задач без танцев с бубном. Второй — операционные процессы: классификация заявок, маршрутизация тикетов, извлечение реквизитов из PDF, проверка заполнения форм. Третий — аналитика и BI: подготовка гипотез, генерация SQL-скриптов, разметка данных для последующих моделей, сверка метрик по логам.

На уровне инфраструктуры эти контуры легко свести с Workspace и AppSheet. Экспорт логов в BigQuery дает наблюдаемость: можно смотреть, какие подсказки и промпты работают, где частые переспрашивания, сколько контекста уходит на задачу. AppSheet с ИИ-задачами позволяет «прибить к столу» полу-ручные шаги: дефектолог заполняет карточку, ИИ вытаскивает сущности, менеджер видит итог в структуре. Никакой магии — просто дисциплина данных и возврат времени команде.

Где проще всего стартовать

Я обычно начинаю с того, что не требует согласований на полгода и не трогает критичные системы. Беру один процесс из поддержки или маркетинга, где уже есть критический объем ручных действий. Ввожу мультимодальный шаг — например, автоматическое извлечение пунктов договора из скана и сравнение с шаблоном. Сверху кладу метрики: доля корректных извлечений, среднее время обработки, сколько человеко-часов вернули. Через неделю к потоку добавляю ещё одну ветку и аккуратно масштабирую.

Выбирайте задачи, где выигрыш в минутах умножается на сотни повторений. Именно там ИИ быстро окупает настройку.

Найдите один процесс с повторяемостью и понятной метрикой успеха. Подключите Gemini как мультимодальный шаг, обеспечьте логи и проверку качества. Дальше будет проще убедить остальных.

Интеграции на n8n и Make.com: как я собираю контуры

Скелет потока в n8n

Самая стабильная заготовка у меня выглядит так: триггер — нормализация входа — нода контекста — вызов Gemini — постпроцессинг — ветка логирования — ветка алертов. Триггером выступает вебхук, письмо или событие в очереди. Нода контекста собирает промпт: короткая роль, формат ответа и чек-лист ограничений. Вызов Gemini — через HTTP Request с ключом в зашифрованных креденшелах, троттлинг на уровне ноды, ретраи на 429. Постпроцессинг приводит ответ к JSON-схеме, проверяет поля и пушит в хранилище. Логи улетают в отдельный индекс, алерты — в корпоративный мессенджер.

Секрет устойчивости простой: разбейте подсказку на блоки и храните их как версии. Тогда правки не затрут рабочий пайплайн и вы сможете откатиться. И да, я всегда добавляю тестовую ветку в n8n, где гоняю 10-20 кейсов каждый раз после изменения промпта. Иногда с третьей попытки — ничего, зато спокойно сплю.

Make.com для быстрого прототипа

Когда задача требует проверить гипотезу за вечер, включаю Make.com. Там сочетаю модульный вызов модели, работу с файлами и встроенные валидаторы. Для мультимодальных задач удобно держать узлы: загрузка изображения, преобразование PDF в изображения, объединение текста и картинок в один запрос. На выходе — запись в Google Sheets, письмо менеджеру и сторидж файлов. Если прототип «выстрелил», переписываю на n8n, где мне удобнее вести версионирование и контролировать окружение на своем сервере.

Формула подсказки и контроль формата

Мой базовый шаблон промпта для сервисных задач состоит из четырех частей: роль и правила, контекст задачи, формат ответа в JSON с обязательными полями, критерии отказа. В n8n я валидирую выход через JSON Schema и на ошибке отправляю повтор с более строгой инструкцией. Плюс держу словарь запрещенных источников данных и фразы, которые модель не должна использовать. Это не бюрократия, а страховка. Да, иногда модель гладит края текста слишком бодро — поэтому требование к конкретному формату и пример валидного ответа помогают держать качество.

Соберите повторяемый каркас, разделите подсказку на версии и жестко валидируйте форматы. n8n — для управляемых конвейеров, Make.com — для быстрых прототипов и экспериментов.

Данные, 152-ФЗ и практики безопасной передачи

Белая зона данных и минимизация

Я работаю в white-data-зоне, и вам советую: не отправляйте в модель то, что под персональные данные или коммерческую тайну, если нет законного основания и согласованных процедур. Сначала деидентификация: заменяем ФИО на маркеры, убираем прямые контакты и реквизиты. Потом минимизация: отправляем только те фрагменты, без которых модель не решит задачу. Логи и контроль — обязательно. Это простые шаги, но они на удивление сильно снижают риск и успокаивают службу безопасности.

Где хранить и как логировать

Логи взаимодействий — отдельно от бизнес-данных. Если у вас уже есть BigQuery внутри корпоративной инфраструктуры, экспортируйте метрики обращений и шаблоны подсказок туда. Если нет — достаточно собственного хранилища с аудит-логами на вашем сервера. Важно, чтобы вы умели ответить на три вопроса: что отправили, что получили, на основании чего модель выбрала такой ответ. Для внутренних расследований и аудита этого достаточно.

Реалии российского контекста

Сервисы Google в России живут с нюансами доступности, поэтому инфраструктуру разумно строить с учетом резервов и локальных компонентов. Я использую прокси-слой, очереди, кэш и очередные ретраи. Всё-таки стабильность важнее гиперскорости. И обязательно документирую список задач, которые разрешено гонять через внешний ИИ, а какие оставляем на внутренние модели или локальную обработку. Так проще соблюдать 152-ФЗ и договоренности с заказчиком.

Лучший друг интегратора — принцип «минимально достаточный контекст». Чем меньше выносите наружу, тем спокойнее спите.

Белая зона данных, деидентификация, минимизация и аудит-логи. Это скучно, зато работает годами.

Готовые сценарии: поддержка, документы, аналитика

Техподдержка и сервис-деск

Сценарий: клиент прислал скриншот ошибки и короткое описание. Поток: n8n берет картинку и текст, Gemini классифицирует проблему и предлагает 3 шага решения, добавляет код фрагмента конфигурации, если это нужно. Дальше нода проверяет покрытие базы знаний и либо обновляет статью, либо ставит задачу редактору. Метрика — доля тикетов, закрытых без эскалации, и среднее время ответа. Короткий цикл, минимум ручных операций.

Документы и соответствие шаблонам

Сценарий: приходит договор или акт в PDF. Поток: Make.com преобразует PDF в изображения, Gemini извлекает ключевые поля и сравнивает с эталонным шаблоном, помечает расхождения. n8n валидирует JSON и рассылает ответственным. При частых ошибках запускаем обучающую врезку для менеджеров. Метрика — доля корректных извлечений и время цикла от входа документа до статуса «готово».

Аналитика и BI-подсказки

Сценарий: нужно быстро подготовить SQL-черновик для проверки гипотезы. Поток: Gemini получает схему таблиц, гипотезу, примеры запросов. На выходе — корректный запрос с комментариями и предохранителями. Далее идет автозапрос с лимитом строк и отправка результата аналитику в песочницу. Метрика — доля запросов, прошедших проверки без правок, и сэкономленное время. Опционально подключаю резюмирование результатов для менеджеров без технического бэкграунда.

Три сценария закрывают 70% типовых потребностей — поддержка, документы, аналитика. Остальное — вариации и расширение набора источников данных.

Метрики качества и контроль разумных агентов

Что измеряю всегда

Есть базовые вещи, без которых я не включаю процесс на полную. Точность извлечения по эталону, доля ответов с правильным форматом, среднее время на задачу, доля ретраев, частота эскалаций к человеку. Плюс качество промпта: сколько токенов жрет контекст, насколько последовательно модель следует инструкции, как влияет длина ответа. Это не абстракция — именно эти цифры потом помогают аргументировать решения перед руководством и безопасниками.

Как контролирую агентов

В агентной логике у меня всегда есть критик. Это второй вызов модели, который проверяет ответы на соответствие политике и формату. Если критик недоволен — идем на повтор с уточнением. Добавляю эвристики: максимальная длина, запрещенные утверждения, проверка ссылок. Отдельно храню эталонные наборы задач и гоняю их при каждой правке. Не очень романтично, зато устойчиво.

Агент — не человек, его совесть называется валидатор.

Метрики и критик-узел дают ту самую прозрачность, ради которой мы вообще строим автоматизацию. Без них сложные процессы превращаются в рулетку.

Подводные камни и чем их обходить

Контекст и стоимость обработки

Большое контекстное окно — это хорошо, но слишком большой контекст делает ответы вязкими и дорогими с точки зрения ресурсов. Правило простое: не тащите всю переписку, держите компактную фактуру и краткий профиль задачи. Кэшируйте векторные представления документов, чтобы не отправлять повторно. И помните про лимиты скорости — их лучше ловить ретраями и очередями, чем останавливать процесс.

Формат ответа и мультичасть

Когда вы комбинируете текст и изображения, модель может «съехать» с формата. Лечится явной JSON Schema и коротким примером валидного вывода. Для цепочек с несколькими модальностями лучше дробить на два вызова: сначала извлечение, затем интерпретация. На бумаге кажется дольше, по факту — стабильнее и быстрее.

Организационные ожидания

Нередко от ИИ ждут волшебства. Я заранее проговариваю, что мы строим инструмент, а не новые должности. Добавляю прозрачную доску задач, где видно, какой шаг забирает время. После первой недели цифры обычно снимают лишние вопросы. Если, конечно, мы их честно собираем.

Экономим контекст, держим жёсткий формат, даем реалистичные ожидания. Становится тише, процессы — стабильнее.

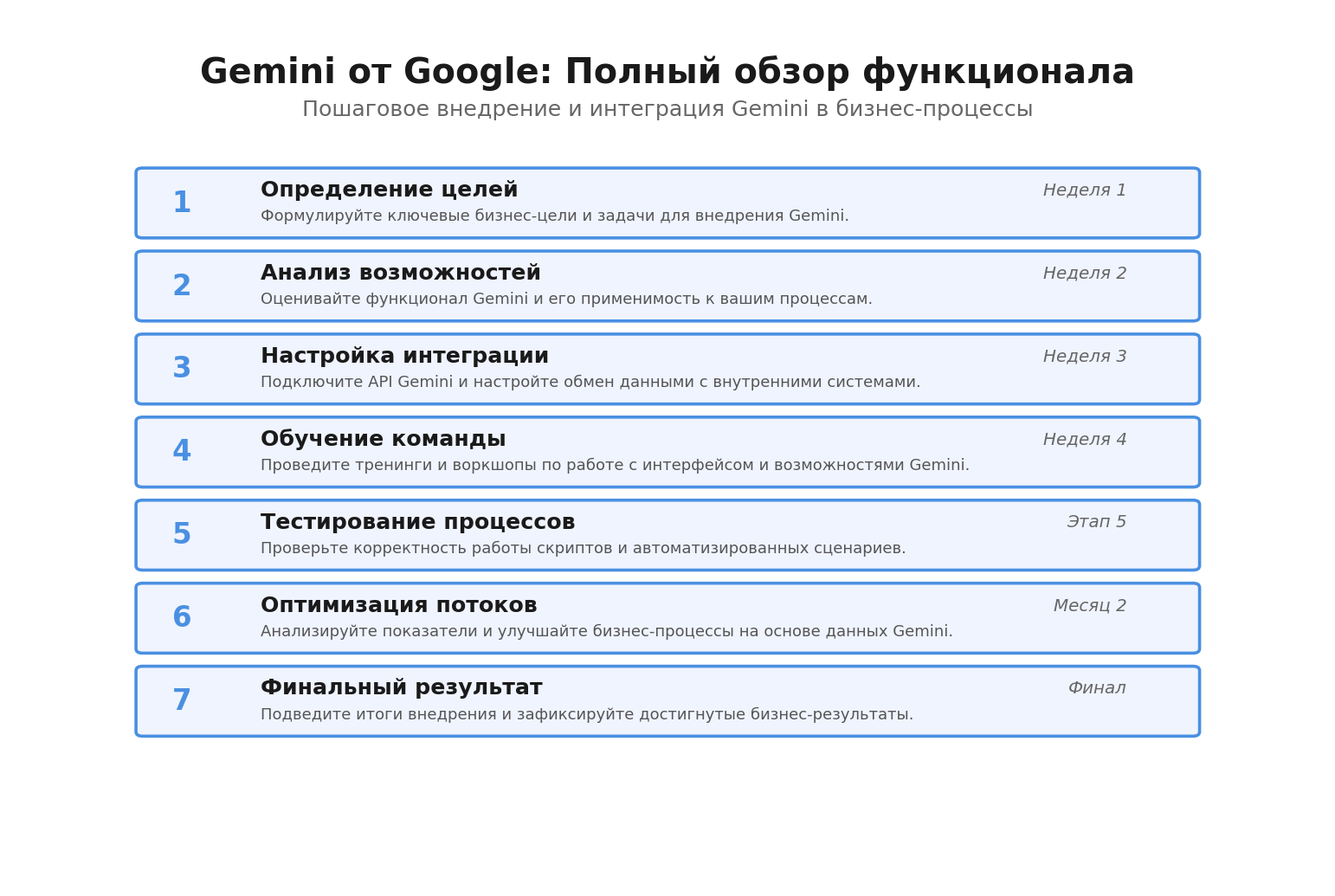

Практические шаги на старте

Чтобы не потеряться в деталях, я всегда иду простой дорожкой. Ниже — рабочая последовательность, которая у меня повторяется из проекта в проект, и, что приятно, не требует героизма. В конце добавлю пару ссылок, где я сохраняю заметки и необычные решения — там удобно посмотреть сопутствующие схемы и шаблоны.

- Выберите один процесс с высокой повторяемостью и фиксируемой метрикой успеха. Пример: извлечение полей из входящих PDF.

- Ограничьте контекст — оставьте только нужные фрагменты и деидентифицируйте данные. Заведите таблицу соответствий маркеров.

- Соберите каркас в n8n: триггер, нормализация, вызов Gemini, постпроцессинг, валидация JSON Schema, логирование.

- Добавьте критика: второй вызов модели с проверкой формата и политики. В случае провала — повтор с уточненной инструкцией.

- Включите логи и экспериментальные метрики: точность, время ответа, доля ретраев, доля эскалаций. Снимайте цифры неделю.

- Расширьте сценарий на второй тип входа — например, добавьте изображения или таблицы. Проверьте, что кэш снижает нагрузку.

- Задокументируйте правила белой зоны данных и список допустимых задач. Согласуйте с безопасностью и командой.

Если хочется увидеть, как это выглядит в бою, я периодически разбираю такие цепочки и выкладываю разметку подсказок и схемы узлов в своём телеграм-канале — аккуратно, без «подписывайтесь». Вот здесь обычно появляются примеры интеграций и наблюдения из проектов — телеграм-канал MAREN. А общий контур того, чем я занимаюсь, с кейсами и материалами — на сайте MAREN. Без спешки, просто знакомство и практика.

Мне нравится, что Gemini двигает нас в сторону нормальной инженерии. Мультимодальность решает бытовые задачи — извлечь, подсветить, сверить, разложить по полочкам. Интеграции с Workspace и AppSheet добавляют приземленной силы — логи, задания, валидные выходы, меньше хаоса. А связки на n8n и Make.com дают ощущение, что процесс не хрупкий: можно версионировать, тестировать, возвращать изменения и спокойно жить с ретраями.

Если смотреть трезво, сильные стороны уже понятны: работа с разными типами данных, устойчивость в длинных цепочках, нормальная аналитика по логам. Слабые — привычные для любой LLM: нужно следить за контекстом, форматом, обещаниями модели и здорово прибивать всё к земле валидаторами. Это, кстати, отличная дисциплина для команды. Не нужно ждать чудес, лучше аккуратно строить свои маленькие «фабрики задач». Оно тихо работает и экономит часы. Иногда именно этого и хочется — чтобы процессы не шумели, а делали свою работу.

Частые вопросы по этой теме

Чем Gemini отличается от классических LLM в процессах

Главное отличие — мультимодальность и интеграции вокруг продуктов Google. Он одинаково принимает текст, изображения, аудио, видео и код, что упрощает конвейеры. Плюс есть логи в Workspace и задачи в AppSheet, которые удобно встраивать в бизнес-потоки.

Как выбрать между Pro, Flash и Ultra

Если вам нужен баланс качества и скорости для бэкенд-процессов — берите Pro. Для массовых быстрых вызовов с низкой задержкой — Flash. Ultra имеет смысл, когда критично качество рассуждений и длинный контекст, но он тяжелее в ресурсе.

Подходит ли Gemini для российского контекста с 152-ФЗ

Да, при корректной работе с данными: деидентификация, минимизация, аудит-логи. Вынесите чувствительные поля из запросов и храните логи на своей стороне. Так вы снижаете риски и сохраняете прозрачность.

Что проще автоматизировать в первую очередь

Классификацию тикетов, извлечение полей из PDF/изображений, резюмирование встреч. Эти сценарии быстро показывают эффект, а метрики легко снять. Дальше можно подключать аналитику и простые агенты.

Как держать качество на уровне без ручного контроля

Используйте JSON Schema, критик-узел, эталонные наборы задач и метрики формата. Добавьте ретраи и очереди. Такой набор покрывает большинство «срывов» и держит стабильность.

Когда лучше Make.com, а когда n8n

Make.com удобен для быстрого прототипа и проверки гипотез. n8n комфортнее для стабильных конвейеров, версионирования, работы в своем окружении и тонкой настройки ретраев и троттлинга.

Нужен ли отдельный OCR, если есть мультимодальность

Чаще нет, Gemini справляется с извлечением из изображений и PDF без внешнего OCR. Но в сложных документах лучше комбинировать: сначала извлечение, затем интерпретация, и проверка формата на выходе.

Метки: chatgpt, контент-план